新闻稿

趋势洞察 | 跨越AI临界点,需要的不止是更强的芯片— GTC归来,对AIDC的设计与建设思考(二)

以下文章来源于GDS PiloTalk ,作者刚爷

引言

越来越多的人相信,我们正在跨越AI临界点,一个由通用人工智能定义的全新世界即将诞生。正像黄仁勋在2024年GTC大会上说的:The future is generative(未来是生成的)。

时隔5年,GTC重回线下,芯片依然是这场盛会中不变的明星,而AI似乎已经成为了这位明星梦想中的舞台。

然而,当更多人还在为地表最强GPU Blackwell B200狂欢时,作为数字基础设施领域的从业者,我们在艳羡过后,确实应该尽快冷静下来,去认真地想一想AI时代的数据中心将要何去何从。

所以,接下来我们将以一位GTC2024亲历者及数据中心从业者的双重视角,浅谈笔者对AIDC相关核心技术及趋势的思考。

一、面对AI业务的快速发展,数据中心基础设施的产品定位要素是什么?

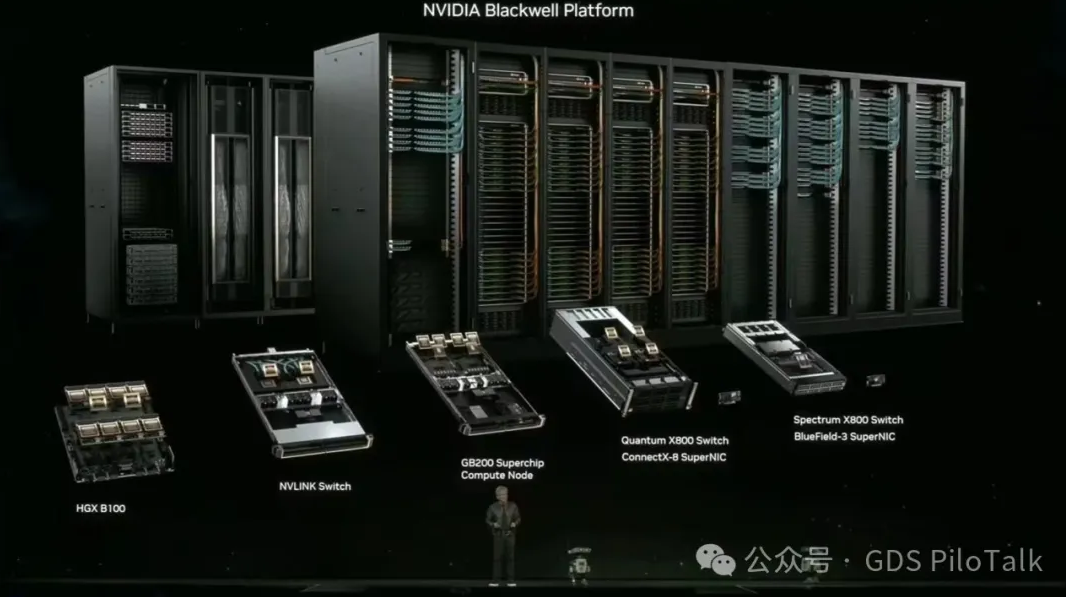

1. 平台——Blackwell platform

黄仁勋在 GTC2024会上反复提及,Data center as a GPU, GPU as a platform。对数据中心基础设施而言,无论服务器密度需求怎么变,其为服务器提供长期有效的散热和供电的基本需求不会改变,服务器密度提升的趋势也不会改变。为了适应芯片技术的不断发展,数据中心基础设施建设不能再是一个风火水电为主的工程项目,需要全面转向产品化,而应对需求变化的核心要素为产品平台化。我们需要准确识别DC基础设施的恒定参数和潜在变量,构建由1个DC建筑模型+多个标准机电模块组件的DC产品平台。基于不同的业务需求,以标准化的机电模块组件在DC建筑模型上快速组合出灵活兼容的定制化DC产品,兼顾产品标准化、建筑合规性、客户需求匹配、法规流程匹配等不确定性因素。未来,DC基础设施服务商的核心竞争力之一,就是打造DC产品平台的能力。

2. 通用——Form fit concept

同样是英伟达B200芯片, 既可以兼容到H100现有的DGX平台中,在现有电气、暖通及软件配套系统完全不做调整的情况下继续应用到现有的DC中;也可以组成GB200超级芯片,进而构成GB200计算节点,从而构建NVL72超级GPU。

同理,DC机电方舱组件的设计和开发也需要考虑不同服务器代际产品迭代的影响,保证在多型号DC平台内的通用性,必须以此为基本原则升级迭代。仅考虑本专业本系统产品的极致优化只会使得DC平台的通用性大幅下降,重新开发DC平台带来的周期、成本及质量上的影响往往是隐性且难以估量的。

3. 融合 —— 数据中心业务跨领域融合的必要性

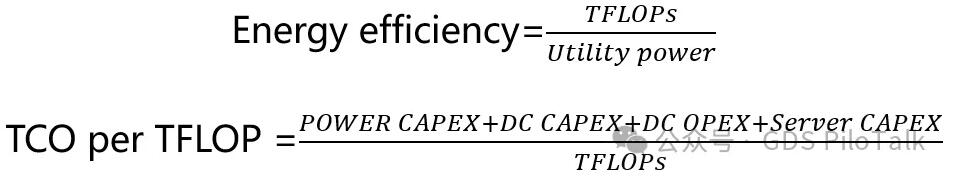

在传统的数据中心业务流中,能源、数据中心基础设施以及服务器网络是三个相对独立的上下游板块,未能有效整合成一个有机的整体,进而发挥最大的效能。数据中心业务的本质实际是通过建设基础设施+网络服务器配套应用,将电力转化为算力,想要将电力直接转化为算力的效率不断提升,就必须进一步考虑数据中心上下游领域的技术融合,也会直接影响到DC产品平台技术方案的选择。我们应该更全面的关注两个技术经济指标,Energy efficiency —— 单位电力算力转化系数;以及TCO per TFLOP —— 单位算力的N年TCO

参考英伟达最新B200发布的数据,其同等算力情况下Energy efficiency 提升了25倍,而服务器CAPEX占DC总体TCO的80%,只要有任何方式可以提高GPU的单位算力,都是值得考虑的方案。以风冷GPU服务器送风温度为例,若降低送风温度能够有效提升单位芯片算力转换效率,则适当牺牲通常我们在传统基础设施侧最关注的PUE指标也是完全可以接受的。基于此,也不难理解黄仁勋为什么可以如此有底气地说出即便是友商的芯片价格为0,也无法和NVIDIA芯片进行竞争的豪言壮语了。

4. 解耦 —— 基础设施与业务需求的解耦

跨领域融合解决了数据中心整体TCO效率的问题,但这并不意味着基础设施的系统和服务器设备要深度结合在一起。相反,我们需要更加清楚地认识到业务需求长期变化的本质,也就是基础设施侧的产品定位应尽量与服务器业务需求解耦,避免由于业务变化对基础设施带来颠覆性的调整。

这里的解耦不仅仅指的是物理上避免耦合在一起,如以前比较流行的一体化模块,在面对机柜密度变化时会呈现的颗粒度匹配问题;也包含系统上下游及专业间匹配逻辑上的解耦,如HVDC——列头柜——机柜配电,当客户机柜密度发生变化时,单台HVDC配电匹配的逻辑将会发生混乱,从而丧失经济性和运维便利度;亦或是风冷、液冷设施配电与IT深度耦合在一个电力模块,制冷需求的变化导致电力模块的变化,从而产品化效率下降。我们需要将基础设施模块组件定位到合适的颗粒度,以应对不断变化的应用需求。

二、芯片技术的高速迭代,将引发数字基础设施发生哪些技术变化趋势?

芯片密度不断提升的趋势不会改变,客观上需要数据中心基础设施技术层全专业维度的迭代升级,以最大可能的去适配未来更高芯片密度,所带来的高速变化趋势。单rack scale密度的飙升,衍生到单DC密度的飙升,不断提升建筑利用效率,在有效的空间下匹配更大容量的GPU容量,从而实现质变的算力特性,会逐步成为AIDC设计和建设的主导趋势。

1. 电气维度

更合理的配电架构:从中国数据中心高速发展的这些年来看,2N配电架构体系由于其运维便利性和安全可靠性的优势,即便是成本高,面积效率低,也长期占据中国数据中心整体规划设计的主流。在机柜密度较低的CPU时代,2N架构并未成为显著的限制因素,行业内没有过多的驱动力去改变现状。在机柜密度不断上涨的今天,机电系统的面积效率也会影响到最终GPU的总体容量和规模,从而影响算力的规模和效率。由此,海外同行长期使用的DR/BR N+1的冗余架构,可以提高配电系统的利用率,在未来应该得到进一步的推广,保证在有效的空间下实现更大的算力。至于大家一直担心的N+1系统的可靠性及维护便利性问题,有诸多有效的手段来解决。笔者认为,一套设计考虑完整的N+1系统的可靠性,不会低于我们现有常规的2N架构设计,是时候向海外友商全面看齐了。

更高密的配电设备:传统的供配电架构下,不同层级的配电架构有诸多冗余配置,占用面积大,成本也不好,已经无法适配DC单体容量迅速提升的需求。我们应该采用电力模块预制集成的方案,倒逼配电架构和设备选型层面的优化,去除传统设计中的一些保守思路,打造适配未来AIDC业务需求的高效电力模块。如今的模块化UPS都已推出高功率密度的模块,这也会进一步助力电力模块尺寸和效率的优化。同时,集中式的UPS+备电系统也会继续维持主流,曾经颇受关注的自带BBU的分布式配电架构方案,随着单机柜功率的不断上涨,将会因为失去通用性而受到挑战。

更高密的备电设备:长久以来,阀控铅酸电池占据了数据中心的应用市场,但是铅酸电池的承重、空间需求限制了DC整体容量的提升,使其成为面积效率提升的关键瓶颈之一。锂电作为提升面积效率的有效手段,始终因其存有安全性的质疑,未能在中国市场进行有效推广。然而,锂电在海外市场已成为数据中心备电的必选项,本质上还是由于海外市场高昂的建筑成本倒逼的结果。通过合理的消防防护和物理隔离措施,锂电方案能有效降低风险发生概率,在未来AIDC的规划设计中将更加广泛的应用。

更集成的配电系统:当前GPU服务器寿命通常为3年,3年以后,新一代的服务器功率变化有多大?实际上难以预测。传统的UPS输出柜——电缆——列头柜的供电方式将面临巨大挑战。UPS输出侧若能够从传统的电缆,全面升级为大母线+小母线配电系统,则能够从容应对未来服务器应用的各种变化,而不会由于末端服务器密度的变化从而导致机柜、列头柜、UPS输出柜的调整。笔者曾经也是列头柜配电的忠实拥护者,安全、可靠、成本低。如今,当我们面对这种更高层级的需求时,突然发现,曾经可以因为100个理由选择Say No的,如今只需要一个理由就能够Say Yes!这也是我们技术工作者长期以来的困惑,如何站在全面TCO的维度去评估、选择一个长期有效的方案, 需要我们建立对未来需求的预判能力,更要有一种长期自我肯定与自我否定的批判意识。

2. 暖通维度

液冷成为散热解决方案的基本选择:在很长的一段时间里,风冷和液冷都能解决服务器的散热问题,选择液冷作为制冷方案,更多是为了实现更好的能效,每次方案比选还要分析经济性、可靠性。如今,芯片密度提升到只能通过液冷解决后,使问题变得简单,现在大家讨论的都是如何有效降低液冷成本和提高液冷可靠性的问题。随着芯片密度的进一步提升,单套GPU的集成度日趋集中,单台服务器的物理空间越来越小,单相冷板液冷的水温会越来越低,丧失PUE效率优势,更高效率的相变冷板技术将会成为行业内的热门话题和研究方向。同时,传统可以通过风冷散热的非GPU芯片和元器件也可能需要采用浸没式液冷来解决。需要说明的是,液冷无法完全取代风冷机柜的需求,对于数据中心基础设施服务商而言,风液兼容的产品解决方案是必须要考虑的课题。行业里对风液兼容如何应对已经有多套解决方案,笔者在此不用赘述,要知道任何兼容都是有代价和局限性,确定不同类型风液兼容方案的适用场景和选取原则,更是一个值得研究的课题。

更高密的风冷制冷方案:120kW的NVL72机柜中仍然有20kW左右的风冷芯片散热需求,同时,与NVL72配套的其他网络柜本身风冷散热密度也不低。因此,即便是20kW的风冷机柜需求,采用当前主流的150kW左右的传统精密空调,也会成为限制空间利用率的关键因素。因此,在液冷方案研究进行的如火如荼的同时,风冷解决方案中300kW~400kW以上大容量的房间级风墙,将会在未来的几年内陆续成为应用选择,从而使得单平方机房面积内可以支撑的风冷散热密度进一步有效提升。

冷冻水系统的回归:近年数据中心制冷系统经历直接新风、间接蒸发冷却、冰川、热管空调等各式各样新技术的应用探索,冷冻水系统作为制冷系统的成熟解决方案,由于其集中式特性,可靠性低、故障域大、预制率低而不受待见。然而,随着液冷系统的出现,水系统的应用又重新回到了人们的视野。NVIDIA最新的120kW机柜液冷方案里,黄仁勋提到的液冷二次侧给水的温度为25℃,这也和ASHRAE报告中关于高功率芯片液冷给水温度的建议值逐步下降的趋势匹配。在如此背景下,考虑到未来液冷的兼容性,回归到冷冻水系统似乎再次成为一种不错的选择。为了解决水系统的集中式故障域风险,通过降低冷站颗粒度,提升产品预制化率,搭建双冗余互联的N+1系统架构等方式,采用分布式、预制化的小型模块化风冷或水冷冷站,是未来通用制冷方案可以考虑的方向之一。

结语

世界唯一不变的就是变化本身,数据中心基础设施产品的基本应对策略:

以不变应万变——产品定位在融合与解耦方面找到平衡点和基准点,任何逻辑不要突破这个底层的业务逻辑,避免过度跟随,也避免停滞不前。

极致技术的追求——在顶层思想不变的基础上,我们需要针对各项技术的演进,不断追求极限,从建筑、电气、暖通、消防、弱电等层面寻找到更优的基础技术优化,以实现DC整体产品的迭代升级。

拓宽视野,跨越周期——比选技术方案时,需要将长期收益定为价值评估基准,以抵御短期利益的诱惑。

知易行难,愿与同行们共勉、共进。

京公网安备 11010502051891号

京公网安备 11010502051891号